BOB半岛体育真没想到百度智能云居然变成这样了!

BOB半岛体育大模型的崛起,宛如一场技术革命,迅速蔓延至云计算的每一个角落。过去,云计算的竞争更多集中在计算资源的规模和成本上。然而,随着AI大模型的不断演进,企业对计算资源的要求早已超越了传统范畴。如今,训练一个具有千亿级、甚至万亿级参数的大模型,需要的不仅是巨大的算力,还包括高度优化的计算架构和无缝衔接的部署能力。传统的云服务架构在面对如此庞大的计算需求时,显得力不从心,亟需一场从底层架构到应用层的全方位革新。

这也引发了一个全新的市场竞争局面:什么样的云厂商能够在这场竞赛中脱颖而出,赢得未来的市场青睐?是能够提供最强算力的厂商?还是那些能在复杂的计算任务中保持卓越稳定性的服务商?亦或是那些能够将大模型应用广泛覆盖到各行各业的全能型选手?或许,2024百度云智大会能给我们一些启示。

要理解大模型时代的智能云服务的力量,我们得先拆解一下它的“魔法”是如何施展的。就像一栋高楼,智能云服务也有自己的基础、结构和顶层,每一层都至关重要。让我们走进这座“云端摩天大楼”,一层一层地探索它的奥秘。

首先,我们来到这栋大楼的“引擎房”——计算集群层。这里是整栋楼的“心脏”,它决定了整栋大楼是否能够高速运转。你可以把它想象成一支强大的团队,负责处理所有繁重的任务,从数据运算到模型训练,全靠他们。

GPU计算集群是这个团队的明星成员。GPU就像那些高效能的超级员工,能够同时处理成千上万的任务。想象一下,你的团队需要在最短时间内处理一座图书馆里的所有书籍,GPU就是那批能够同时翻阅上千本书的超级助手。它们的并行处理能力,尤其是在深度学习中,简直无可替代。然而,随着任务的复杂性增加,单纯依赖这些超级助手还不够。团队需要进一步扩展,增加更多的GPU,并优化任务分配,确保每个成员都在最适合的位置上发挥最大效能。

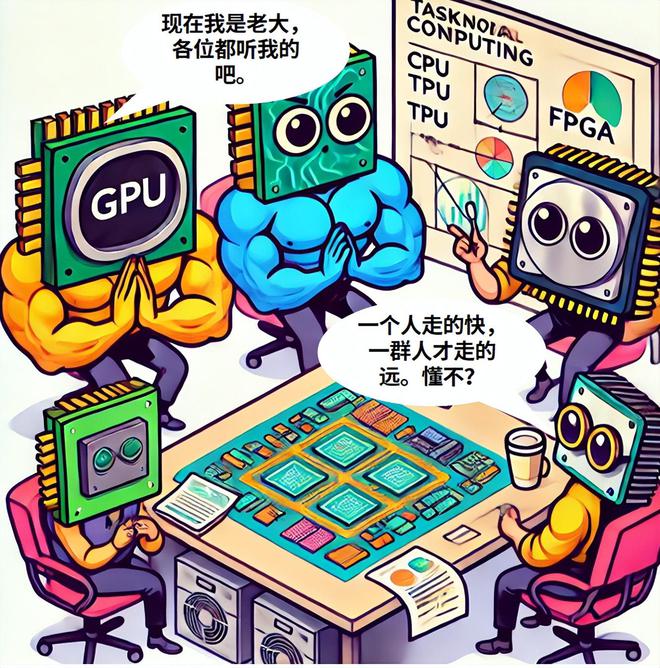

但是,光有一群超级助手还不足以应对所有挑战。于是,我们引入了异构计算集群,这就像把各类专家招募进团队。GPU、CPU、TPU、FPGA,这些“专家”各有所长:GPU擅长同时处理大量任务,TPU(张量处理单元)对深度学习的优化得心应手,而FPGA(现场可编程门阵列)则在处理特定的定制化任务时表现不凡。当然,CPU在处理一些日常任务的时候也必不可少。团队的任务调度系统必须聪明地分派工作,确保每个专家都发挥特长。同时,我们还要时刻留意能耗,毕竟让专家们同时全力工作可是相当耗电的。

然而,即便团队成员再强大,他们的效率也会受到数据流动的影响。这就需要高性能存储与网络来保证数据在团队中快速流动。你可以把它们想象成团队的“快递小哥”,他们需要在最短时间内把任务数据送到每个成员手上。低延迟、高吞吐量的存储系统和高速互联网络确保数据能够迅速抵达,避免因交通堵塞而拖慢工作进度。

在竞争中,服务商的硬件支持与扩展性就像是这支团队的“灵活性”——能否快速调整队伍规模,适应不同任务的需求。部署速度与稳定性则反映了团队的“应急能力”,是否能在突如其来的任务中迅速反应,保持稳定工作。而最终BOB半岛体育,性能与性价比的平衡决定了这支团队是否值得雇佣——毕竟,高效且成本合理的团队,才是客户眼中的香饽饽。

接着,我们来到这栋大楼的“智囊团”——大模型平台层。这里是整个系统的大脑,负责将计算能力转化为实际成果,推动创新应用。

模型开发与训练是这个智囊团的核心任务。你可以把它想象成研发部门,他们负责设计、开发和优化各种模型。这些模型就像是产品的蓝图,越精确,产品的质量就越好。自动化调优技术则是他们的秘密武器,帮助他们快速找到最佳设计方案,而高效的分布式训练框架则让他们可以同时开发多个项目,提升整体效率。

但开发出优秀的产品只是第一步,模型推理与服务则是将这些产品推向市场的关键。推理速度和服务质量直接影响用户的体验,就像是产品的交付速度和售后服务。平台需要确保每个模型在生产环境中都能稳定运行,并且在用户需要时迅速响应。

此外,工具链与易用性是智囊团的“辅助工具”。丰富的开发工具链就像是为团队提供了全套的高效工具,让每个成员都能发挥最大潜力。通过这些工具,平台能够吸引更多的开发者和企业客户,形成强大的用户群体。

在市场竞争中,模型创新与覆盖范围决定了智囊团的“创新能力”和“市场渗透率”。平台不仅需要不断推出新模型,还要确保这些模型能够适应多种应用场景。用户量与市场占有率反映了平台的行业影响力,广泛的用户基础让平台更具竞争优势。而服务稳定性与可扩展性则是智囊团能否持续扩展业务的基础,平台必须确保在面对复杂应用时依然保持高效稳定。

最后,我们来到这栋大楼的“展示厅”——大模型应用层。这里展示的是智能云服务如何在现实中发挥作用,将技术转化为生产力。

在这一层,我们会看到各式各样的大模型应用。比如,通过大模型技术,智能客服已经从简单的对话生成进化到能够处理复杂问题、提供个性化服务的智能助手;数字人也是一个重要应用,通过大模型和虚拟人技术,企业可以创造出逼真、生动的虚拟角色,这些角色不仅用于娱乐和营销,还开始渗透到虚拟购物、教育等领域,为用户带来全新的体验。

面向各个行业,垂直行业解决方案则展示了大模型如何在各个行业中落地生根。无论是在教育、医疗,还是金融领域,大模型都可以提供定制化的解决方案,帮助各行各业提升智能化水平,推动业务升级。

在这些领域的竞争中,客户量与市场渗透率反映了展示厅的“人气”,吸引更多的企业用户,让他们看到大模型的实际价值。行业覆盖广度与业务丰富度决定了展示厅的“多样性”,能够为不同客户提供丰富的解决方案。而用户体验与反馈则是提升展示厅声誉的关键,通过优化用户体验,展示厅能够赢得更好的市场口碑和客户忠诚度。

综上所述,智能云服务的成功离不开计算集群、大模型平台和大模型应用三个层次的协同运作。每一层都承担着独特的功能,只有在每个层次上都做到卓越,服务商才能在激烈的市场竞争中占据优势,真正成为行业的领军者。

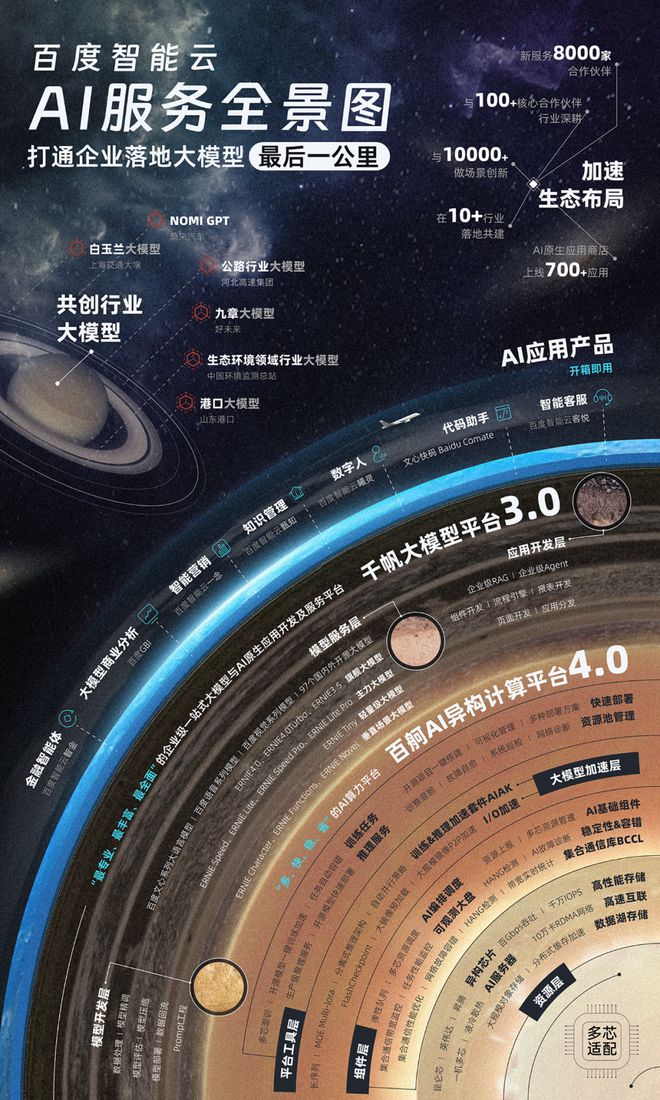

在2024年百度云智大会上,百度智能云展示了其技术实力和创新产品,特别是在计算集群、大模型平台以及应用服务方面的全面布局,推动各行业加速智能化转型。

百舸4.0是百度智能云的核心AI异构计算平台,采用四层架构:资源层、组件层、加速层和工具层。资源层通过支持昆仑芯、昇腾芯片、海光DCU、英伟达GPU等多种异构芯片,实现了高效的算力管理与资源整合。组件层提升了大规模集群的稳定性和性能,通过智能任务调度和资源分配,确保集群在高负载下依然高效运行。加速层则通过优化通信和并行策略,为大模型训练和推理提供显著的速度提升。

目前,基于在平台,万卡集群下,万亿MoE模型,结合通信和并行策略优化,训练效率提升30%;在万卡任务上实现有效训练时长99.5%;万卡规模下,两种芯片混合训练下,训练效率折损控制在10%以内;借助百舸所提供的训推一体技术,能够实现高达 90% 的算力资源利用率。

千帆3.0是百度智能云的大模型平台,集成了从模型开发、训练到推理和应用开发的全流程工具链。自千帆1.0推出以来,百度智能云不断迭代升级,千帆3.0在模型开发层、服务层和应用层实现了全面提升。

千帆3.0支持大模型与垂类模型的同步开发,并在模型服务层提供了包括文心旗舰大模型、轻量级大模型和垂直场景模型的多样化选择。平台还新增了语音和视觉系列模型,满足了更广泛的业务需求。在应用开发层,千帆通过企业级智能体开发工具和AI速搭平台,帮助企业在短短几小时内开发出定制化应用,降低了企业进入AI领域的技术门槛。

目前,随着千帆调用量不断攀升,呈指数级增长,各行各业都在尝试通过大模型来重构业务。同时千帆也在行业场景渗透更加广泛和深入BOB半岛体育,从教育、电商BOB半岛体育、企业服务到社交文娱、硬件、座舱等等非常多的领域,也更下沉到业务开发场景和实际使用的每个环节。

在应用层,百度智能云通过“客悦”和“曦灵”两大产品,展示了大模型技术的实际应用。“客悦”智能客服基于大模型技术,提升了拟人度和交互智能,在复杂问题的理解与推理上表现出色。它的多模态交互能力支持文本、图片和语音的混合输入。

“曦灵”是百度智能云的数字人平台,提供从2D到3D的数字人生成解决方案,具有极高的性价比。用户输入简单的文本描述,即可在几分钟内生成逼线D数字人。

此外,百度智能云为企业提供了端到端的行业解决方案,帮助客户在数字化转型中实现智能化升级。这些技术和产品不仅提高了客户服务效率,也增强了品牌的市场竞争力。

需要指出的是,大模型时代的智能云服务正推动各行业的智能化转型,但这一进程并非一帆风顺。虽然我们已经取得了不小的进步,但前面依然存在大量的挑战。

在智能云服务中,异构计算是提升计算性能和效率的关键。然而,在实际应用中,不同芯片架构的协同工作仍面临重大挑战。尤其是GPU与CPU的异构计算,成为当前技术实现中的一大瓶颈。

例如,GPU适合处理矩阵运算,而CPU则在任务调度和控制流处理方面更为出色。为了实现两者的高效协作,需要在任务划分、数据传输和同步机制上进行深度优化。目前,任务调度系统往往依赖于手动配置,缺乏智能化和动态调整能力,这在多任务高并发的环境下容易导致性能瓶颈。此外,不同GPU厂商的芯片协同也是一个亟待解决的问题。英伟达的GPU占据市场主导地位,但随着华为等国产GPU厂商的崛起,如何在同一计算任务中协调不同品牌GPU的工作,是服务商必须面对的挑战。不同厂商的GPU在架构设计、驱动支持和优化策略上存在差异,如何在一个统一的平台上整合它们,实现无缝协同,是未来异构计算技术发展的重点。

随着智能云服务规模的扩大,能耗问题日益突出。大规模GPU集群的能耗极高,电力成本成为服务商面临的一大挑战。尤其是在深度学习模型训练过程中,GPU的持续高负载运行不仅消耗大量电力,还带来了巨大的散热压力,进一步增加了运营成本。

为了应对这一挑战,部分智算中心甚至开始规划使用核能供电,以确保稳定的电力供应并降低长期能耗成本(具体内容参见:不配一个核反应堆BOB半岛体育,都不好意思跟人说是智算中心?)。然而,核能供电是否必要以及其可行性仍然存在争议。一方面,核能可以提供稳定且大规模的电力输出,满足超大型智算中心的需求;另一方面,核能建设成本高,且安全性和环保性受到广泛关注。服务商需要在能耗管理和电力供应策略上进行权衡,可能的解决方案包括开发更高效的冷却技术、优化电力调度BOB半岛体育、以及探索可再生能源的利用。

需要注意的是,随着以GPU为核心的异构计算架构在智能云服务中占据主导地位,传统的云计算操作系统面临重构的需求。现有的云计算操作系统,如OpenStack和Kubernetes,主要针对CPU集群进行了优化,但随着GPU逐渐成为核心计算单元,新的挑战也随之而来。

现有操作系统在GPU资源管理上的不足显而易见,当前的操作系统虽然可以管理GPU资源,但对GPU的调度和资源利用率优化还远远不够。GPU的计算特点与CPU不同,尤其是在任务调度和并行任务管理方面,现有操作系统无法充分发挥GPU的优势。因此,我们需要一个新的智能云集群操作系统,它需要专门为GPU、TPU和FPGA等异构计算资源设计,能够更好地调度和管理这些资源。

该操作系统的核心功能,应包括智能化的GPU任务调度、资源动态分配、任务优先级管理、以及跨节点的并行计算优化。此外,这种操作系统还需要支持多品牌、多架构的异构GPU协同工作,提供统一的编程接口和驱动支持,确保不同品牌的GPU可以在同一集群中高效协作。

未来,AI驱动的智能调度系统将成为智能云服务的关键组件。智能调度不仅要考虑当前的任务负载和资源状态,还要具备预测能力,能够提前调整资源分配,确保在负载高峰时系统依然平稳运行。与此同时,自动化运维将进一步从“被动响应”转向“主动防御”。借助AI,系统可以自我监控,识别潜在的故障风险并在问题发生前进行处理,极大提升系统的可靠性。

可以预见,全球智能云市场的竞争将进一步加剧,尤其是在异构计算和大模型应用方面。美国的AWS、微软Azure和Google Cloud将继续发挥技术和市场优势,但中国的阿里云、腾讯云、华为云和百度智能云等,正凭借本地化优势和大模型技术崛起。百度智能云这样的中国云厂商,通过在异构计算的整合与大模型应用上的创新,正在缩小与国际巨头的差距,甚至在某些领域取得领先。

在此基础上,智能云服务正在推动To B行业进入全新的智能化时代。通过整合数据分析、智能决策和自动化流程,企业能够大幅提升运营效率,开发出更加个性化和创新的产品与服务。未来,To B行业的智能化转型将促使传统行业的商业模式发生深刻变革,跨行业协同将成为新的发展趋势,帮助企业在全球市场中建立竞争优势。